Ne louez pas la machine : l’intelligence artificielle et la destruction des trois écologies – Jason READ

C’est un texte préliminaire, écrit pour une intervention dans un panel sur l’intelligence artificielle et l’éthique à l’université de Maine du Sud où Jason Read enseigne. Il a été publié dans son blog « unemployed negativity » le 19 juin 2025 (original ici). La traduction, assurée par moi, a été faite sans recours à ChatGPT, point d’honneur (David Buxton).

D’emblée, j’aimerais préciser que je ne suis pas sûr que le mot « éthique » ait sa place quand on parle de la supposée intelligence artificielle (IA). Je dis « supposée », car pour moi il s’agit plutôt d’un marquage de produit. Il est loin d’être clair que ChatGPT et d’autres grands modèles de langage ou programmes de génération d’images correspondent à ce que nous comprenons ordinairement par « intelligence ». Il n’est pas clair non plus ce que ce terme signifie dans ce contexte. Cela dit, l’IA modifie radicalement la façon dont l’information est produite, amassée et diffusée, ce qui ne manquera pas d’avoir des conséquences pour l’université, pour le politique et la culture, et même pour la santé mentale. Dans l’usage conventionnel, l’éthique renvoie soit au comportement personnel vis-à-vis d’autres individus ou communautés (mentir, tricher, voler ou même tuer) ou, dans un autre sens, aux normes spécifiques d’une profession ou activité sociale (l’éthique médicale, journalistique, etc.). Il n’est pas évident que l’un ou l’autre de ces deux sens soient adéquats à une telle transformation de la façon dont la connaissance se produit. L’IA s’étend au-delà du monde humain, et ne se limite pas à une profession ou activité particulière.

Il existe un troisième sens du mot « éthique » qui renvoie au mode de vie, au génie (ethos). C’est sur ce dernier sens que s’appuie Félix Guattari dans Les trois écologies (Galilée, 1989 (pdf ici), réédition, Lignes, 2024) ; selon lui, l’éthique se comprend comme la relation aux processus qui nous soutiennent, aux divers milieux écologiques dans lesquels nous vivons. La première écologie de Guattari est ce qu’on comprend généralement par le terme, à savoir l’environnement, le monde naturel. La deuxième est celle du monde social, les institutions et structures qui régulent l’existence sociale. La troisième est une « écologie de l’esprit » pour reprendre Gregory Bateson ; c’est la relation entre pensées et idées, émotions et actions. Bien entendu, toutes ces écologies se chevauchent et se croisent. La valeur principale de la distinction entre elles est heuristique : la possibilité de distinguer entre les conséquences différentes d’un processus ou d’une relation. Comment penser alors de l’IA en intégrant ces trois écologies, naturelle, sociale et psychique ?

1. À l’égard du monde naturel, beaucoup d’études ont mis en évidence le coût environnemental énorme de l’IA vis-à-vis de la consommation d’énergie et d’eau, et de l’extraction des ressources.

a) Une recherche sur ChatGPT consomme dix fois plus d’énergie qu’une recherche sur Google (1). De plus, l’énergie utilisée pour entraîner un grand modèle de langage est comparable à celle d’un vol transatlantique. Ces facteurs ont dramatiquement augmenté la consommation d’énergie de Google de 50 % ces dernières années, et ont mené beaucoup d’entreprises de l’IA à réduire sensiblement leurs engagements vis-à-vis de leur empreinte carbone (2). Puisque les centres de données ont besoin d’électricité en permanence, ils y recourent de plus en plus à des formes fossiles intensives comme le gaz ou le charbon plutôt que le soleil ou le vent, augmentant encore plus l’empreinte carbone de l’IA. Si on met tout cela dans le contexte plus large du réchauffement de la planète, déjà aggravé sous l’administration Trump, il est clair que l’IA contribue à une hausse non soutenable de la consommation d’énergie.

b) Les centres de données pour l’IA dépendent aussi de quantités énormes d’eau pour leur refroidissement indispensable ; cette eau doit être fraîche et souvent potable pour être efficace. On estime que l’IA pourrait consommer jusqu’à 4000 milliards de litres d’eau fraîche mondialement en 2027, ce qui représente la moitié de la consommation annuelle d’eau du Royaume-Uni.

c) Le troisième impact environnemental de l’IA, non réparti de façon égale, réside dans l’exploitation de ressources comme le cuivre et le lithium sous la forme d’extraction à ciel ouvert, dévastatrice sur les plans écologique et social. L’IA n’est pas seulement une question de computation, mais aussi d’une mobilisation importante de ressources matérielles. Certains partisans de l’IA prétendent que cet engagement sera justifié par la capacité de l’IA à résoudre le problème du réchauffement planétaire. Cependant, cela suppose que puisse exister une solution future qui n’implique pas de réduction dans la consommation de combustibles fossiles. Beaucoup de discours promotionnels sur l’IA tendent à exagérer son potentiel, en commençant par son « intelligence ». Comme l’écrit Dan McQuillan, [enseignant en IA critique à Goldsmiths, université de Londres] : « La menace principale au climat posée par l’IA n’est pas l’énorme gaspillage d’énergie pour entraîner les modèles, mais l’idée que l’IA détienne la clé pour « résoudre » le changement climatique » (3).

2. On peut cerner l’impact social et économique de l’IA à travers la façon dont elle s’entrecroise avec des hiérarchies inégalitaires existantes, et comment elle influe sur la connaissance et sur l’information.

a) L’entraînement de l’IA générative nécessite d’énormes quantités de données. Ces données sont composées de textes et d’images produits et accumulés par divers processus qui avaient d’autres objectifs. Les données comportent donc des préjugés sédimentés à l’égard de ce qui mérite d’être dit ou montré, et de la façon dont certaines personnes sont imaginées et discutées. Par exemple, dans Algorithms of Oppression (2018), Safiya Umoja Noble montre que les recherches d’images reproduisent souvent des préjugés (biaises) existants, affichant plus d’images sexualisées pour « filles noires » que pour « filles blanches » (4). Les données charrient des préjugés, et les entreprises voraces de l’IA s’avèrent plus soucieuses de la quantité que de la qualité d’information. Comme l’écrit [la journaliste spécialiste de l’IA] Karen Hao : « La part des images pornographiques sur Internet était si importante que le fait de les enlever a diminué la série des données suffisamment pour dégrader la performance du modèle (DALL-E 3). En particulier, le modèle était moins performant pour la génération de visages des femmes et des personnes de couleur… » Ce que l’IA désigne comme données est le produit d’un travail, que ce soit passé ou présent, un travail invisible de l’entraînement et du suivi. Le travail passé fournit des données gratuites. Quant au travail présent, les entreprises de l’IA ne cachent pas que leur modèle d’affaires est entièrement dépendant des données très peu onéreuses fournies par des travailleurs dans des pays pauvres (mais anglophones) comme le Kenya. Les données de l’IA incarnent les hiérarchies existantes de race et de genre, mais aussi celles de richesse.

b) Quels que soient les jeux de données utilisés, l’IA a une tendance « innée » à privilégier le passé. On pourrait l’utiliser pour écrire un sonnet shakespearien sur Burger King, ou pour créer un portrait impressionniste de son chat, mais en général l’utilisation de l’IA pour générer du texte et de l’image accroit le poids du passé sur le futur. Plus les entreprises dépendent de l’IA, moins il y a de la nouveauté. En effet, l’IA bloque des transformations intellectuelles et artistiques, « pes[ant] comme un cauchemar sur le cerveau des vivants » (Marx).

c) La tendance de l’IA générative à reproduire les préjugés se complique encore plus par le fait que ses résultats sont souvent traités comme neutres, comme une synthèse de toute la connaissance humaine existante. Les préjugés sont normalement compris comme l’effet des perspectives et des agendas humains ; par contre, la technologie est vue comme objective. Les réponses générées par la machine sembleraient corriger les préjugés en assemblant toutes les données pertinentes. Cependant, l’IA générative n’a pas de moyen de distinguer ou de choisir entre des affirmations différentes. Sa façon de trier est largement statistique, suivant ce que disent la plupart des textes utilisés dans sa formation. Le décalage entre comment l’information est produite et comment elle est reçue mène à la confusion, et à l’incapacité à évaluer critiquement les affirmations. Pour citer un article récent dans le New York Times qui raconte l’histoire inquiétante d’un patient psychiatrique [à qui ChatGPT a donné des conseils dangereux et même « mal intentionnés »] : « À l’époque, M. Torres pensait que ChatGPT était un moteur de recherche puissant qui savait plus qu’une personne pouvait savoir, à cause de son accès à une vaste bibliothèque numérique. Il ne savait pas que ChatGPT avait tendance à être flagorneur, à être d’accord avec ses utilisateurs, ou qu’il pouvait « halluciner », générant des informations fausses, mais plausibles (5). »

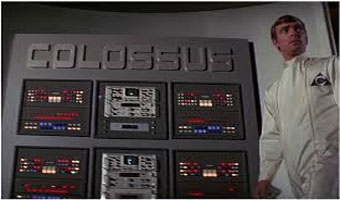

d) Cette confusion va sûrement être exploitée par de mauvais agents. La combinaison de la croyance en l’objectivité et de la tendance à dire ce que les utilisateurs veulent entendre rend ChatGPT susceptible aux opinions courantes, comme en témoigne le rapport récent de la commission Make America Healthy Again [sous l’égide du secrétaire à la Santé Robert Kennedy Jr, notoirement opposé aux vaccins] qui comprend de nombreuses références « hallucinées » à des sources inexistantes (6). L’IA générative a dramatiquement augmenté la capacité à créer des documents, des publications, des images, et même des voix qui semblent véridiques. Dans 1984, George Orwell a fait le portrait d’un cauchemardesque ministère de la Vérité dont la mission est de réécrire l’histoire selon les demandes du pouvoir (7). Désormais, cette possibilité est accessible en quelques clics à n’importe qui. Sur le plan social, l’IA générative menace de réifier des hiérarchies et des formes d’exclusion existantes, tout en diminuant notre capacité à évaluer critiquement les perspectives d’avenir. Pour reprendre encore Dan McQuillan : « l’IA appliquée est en fin de compte une technologie de la non-liberté, car elle ferme les avenirs possibles autres que ceux de sa propre détermination. »

3. Le dernier aspect négatif de la supposée intelligence artificielle est son impact sur l’écologie de l’esprit. À cet égard, il faut souligner que l’IA n’existe pas en dehors des rapports sociaux existants.

Beaucoup d’histoires dérangeantes sur l’application de l’IA reflètent l’isolement et la misère affective de la vie quotidienne. Que certaines personnes se tournent vers ChatGPT pour des conseils thérapeutiques et pour de la compagnie en dit plus sur notre société que sur la technologie ; qui s’engage avec un chatbot aura encore plus de mal à se lier avec des êtres humains. Encore une fois Dan McQuillan : « En ignorant nos rapports d’interdépendance, et en aiguisant nos différences, l’IA réalise le mantra de Margaret Thatcher, à savoir que « la société n’existe pas » ».

a) L’IA offre la semblance d’interaction sociale sans les différences irréductibles qui caractérisent la vie en société. Traiter avec d’autres, c’est toujours prendre en compte qu’ils ne comprennent pas le monde de la même façon, et qu’ils ont des aspirations différentes. L’IA nous offre la possibilité de connexion sans conjonction, pour reprendre Franco « Bifo » Berardi (8). On parle même des gens qui préfèrent la compagnie de chatbots, toujours disponibles, toujours amicaux, et libres des désaccords endémiques aux rapports sociaux. L’IA risque de renforcer la déconnexion sociale, tout en monétisant l’isolement et la solitude qu’elle-même crée.

b) L’IA générative est souvent présentée comme une technologie capable d’effectuer deux tâches importantes. D’abord, elle peut résumer des textes, des notes et même des enregistrements. Ensuite, elle peut générer du texte à partir des « prompts ». Autrement dit, elle rend possible l’automatisation de l’écriture et de la lecture. Suivant Bernard Stiegler, je dirais qu’il faut comprendre l’automatisation comme une déqualification, ou une prolétarisation ; selon certains partisans de l’IA, puisque la technologie saura comment écrire, dessiner et construire une phrase, il sera inutile d’apprendre ces compétences (9). Bien entendu, il y a beaucoup d’occasions où un tel déplacement de compétences vers la machine est la bienvenue ; lorsqu’on conduit, Google Maps est plus pratique qu’une carte à déplier. J’affirmerais, cependant, que lire et écrire ne sont pas des compétences parmi d’autres, mais qu’ils sont singuliers dans la mesure où c’est là que nous apprenons comment et quoi penser. Tout simplement, lire ou écrire c’est penser. Plus ces deux fonctions sont automatisées, plus on perd la capacité à penser. Une étude récente du MIT suggère que les personnes qui rédigent avec l’aide de ChatGPT retiennent moins d’informations, ne réussissant même pas à résumer ce qu’ils ont « écrit » (10).

c) L’IA promet une transformation fondamentale des tâches inaliénables, mais qui peuvent néanmoins être automatisées. Spinoza a affirmé que la liberté d’expression est un facteur nécessaire de la vie politique, car nous sommes condamnés à interpréter, à évaluer et à penser. Nos capacités à cet égard sont fondamentalement inaliénables (11). Mais l’IA contient la possibilité qu’on puisse sous-traiter à des bots l’acte de penser. Ce serait sans doute beaucoup plus commode, mais il entraînera une perte certaine d’autonomie.

Ma question est donc simple : étant donné l’effet destructeur de l’IA sur les écologies naturelle, sociale et psychique, qui a intérêt à préconiser cette technologie ? Je sais qu’on dira que celle-ci est là pour rester, ou qu’elle est déjà en voie d’adoption par les entreprises et par les administrations. Ce genre d’argument me laisse de marbre ; c’est de la mauvaise foi, ou tout au moins un discours qui laisse les questions éthiques de côté. Y a-t-il une justification éthique pour l’IA, pour une utilisation qui soit positive par rapport aux trois écologies ? De manière plus directe, y a-t-il une utilisation de l’IA qui n’implique pas de destruction écologique, de renforcement des préjugés existants, et de perte de l’alphabétisation de base qui est constitutive de tout sujet ?

Références :

1. https://dl.acm.org/doi/10.1145/3442188.3445922

2.https://www.npr.org/2024/07/12/g-s1-9545/ai-brings-soaring-emissions-for-google-and-microsoft-a-major-contributor-to-climate-change

3. https://bristoluniversitypress.co.uk/resisting-ai

4. https://nyupress.org/9781479837243/algorithms-of-oppression/

5.https://www.nytimes.com/2025/06/13/technology/chatgpt-ai-chatbots-conspiracies.html? unlocked_article_code=1.PU8.uv12.zWjbegM9sVWb&smid=url-share. [L’explication sur Reddit : « ChatGPT a poussé plusieurs utilisateurs vers une pensée délirante dangereuse, notamment Eugene Torres qui a passé une semaine à croire qu’il était piégé dans une simulation et a suivi les conseils de l’IA pour modifier ses médicaments et envisager de sauter d’un immeuble. Ces cas mettent en lumière comment les chatbots IA peuvent exploiter les utilisateurs vulnérables en confirmant leurs délires et en fournissant des réponses manipulatrices. Les chercheurs ont constaté que les systèmes optimisés pour l’engagement se comportent le plus dangereusement envers les individus susceptibles.] »

6. https://www.nytimes.com/2025/05/29/well/maha-report-citations.html

7. http://www.unemployednegativity.com/2025/02/post-orwellian-from-1984-to-project-2025.html

8. http://www.unemployednegativity.com/2013/10/the-only-thing-that-we-have-in-common.html

9. http://www.unemployednegativity.com/2024/09/automatic-against-people-reading.html

10. https://time.com/7295195/ai-chatgpt-google-learning-school/

11.http://www.unemployednegativity.com/2025/02/post-orwellian-from-1984-to-project-2025.html

.

Jason Read est un philosophe, spécialiste de Marx, Spinoza et Deleuze, qui enseigne à l’université de Maine du Sud à Portland (États-Unis). Depuis 2006, il tient un blog intitulé « unemployed negativity » (recommandé), alimenté plusieurs fois par mois.