De la science-fiction à la science : le mythe de la singularité – Laurence FAVIER

Article interdit à la reproduction payante.

Contenu

Introduction

Que les développements de la science inspirent la science-fiction n’a rien de nouveau. L’imaginaire que véhicule l’idée d’une intelligence artificielle s’épanouit depuis plus d’un demi-siècle au moins, navigant au gré des innovations introduites par les technologies de l’information et les des transformations qu’elles mettent en œuvre dans la science comme dans la vie quotidienne de chacun d’entre nous (au moins dans les pays riches). Que se passe-t-il donc pour que rapports et ouvrages sur l’intelligence artificielle se succèdent aujourd’hui sur ce thème ? Sans doute les retombées économiques attendues et les problèmes éthiques qu’elles soulèvent y sont pour l’essentiel. Mais le plus étonnant est que les scientifiques eux-mêmes (ou plutôt certains d’entre eux) adhèrent aujourd’hui à l’idée d’un « événement brutal, imminent, majeur et pourtant inéluctable qui va, paraît-il, bouleverser le mode d’existence de l’homme du fait du développement incontrôlable des technologies contemporaines, en particulier, des technologies de l’information et de l’intelligence artificielle […] », écrit Jean-Gabriel Ganascia, professeur d’informatique à l’université Pierre et Marie Curie. Dans un ouvrage paru en 2017 [1], Ganascia examine ce passage de la science-fiction à la science, porté non plus par des écrivains, mais par des scientifiques, car « on ne peut pas, vu la légitimité intellectuelle et sociale de leurs auteurs, les rejeter a priori, sans un examen approfondi » (pp. 20, 15).

Le concept de « singularité »

De plus, le « mythe de la singularité » repose sur une conception simplifiée de l’intelligence selon elle serait un ensemble de fonctions élémentaires reproductibles par un ordinateur. Ses moteurs seraient donc la puissance de calcul et la capacité de stockage. Cette simplification de l’intelligence contredit la connaissance que nous avons des nombreuses facultés différentes qu’elle peut mobiliser pour rendre possibles des activités aussi élémentaires que le calcul ou la lecture.

L’autonomie des machines

Le sens de ce progrès indéfini pensé selon la loi de Moore c’est l’autonomie des machines. Depuis Turing, on pense que cette autonomie pourrait être acquise par la capacité des machines à apprendre. L’apprentissage automatique vise à « doter les machines d’une capacité à construire d’elles-mêmes des connaissances et à les utiliser pour se reconfigurer en réécrivant leurs propres programmes. Il en résulte un accroissement impressionnant de leurs performances dont nous tirons les bénéfices dans beaucoup de nos activités quotidiennes (…) ». Différentes approches ont été explorées avec succès. L’apprentissage automatique couplé aujourd’hui à la masse de données disponibles (Big Data) rend possible cet accroissement des performances dont témoignent le logiciel de reconnaissance vocale Siri d’Apple, la voiture autonome de Google, et le succès du programme d’AlphaGo qui a gagné au jeu de go contre le champion du monde en mai 2017. Doit-on en déduire que les ordinateurs se passeront bientôt de nous pour agir ?

Pour Ganascia, cette possibilité est le signe d’un dérapage risqué autant que d’un progrès car « les ordinateurs se reprogrammant d’eux-mêmes, sans qu’aucun être humain n’ait ni rédigé, ni relu, ni a fortiori vérifié les programmes qui les animent ». Dès lors le comportement de ces machines devient de plus en plus difficile à anticiper et « cette imprévisibilité apparaît neuve, parce qu’elle ne tient pas uniquement à la difficulté que nous avons de prévoir les réactions des machines dans la précipitation de l’action, du fait de leur rapidité, mais au caractère inédit de leurs comportements qui découlent de l’exécution de programmes construits sur des données qu’aucun homme n’a jamais examinées ». L’inquiétude des lettres ouvertes publiées en 2015 par les chercheurs en intelligence artificielle est donc justifiée [2].

Agir plutôt que de fermer les yeux

Mais outre les risques, Ganascia conteste la possibilité même d’ordinateurs pouvant se perfectionner indéfiniment jusqu’à se passer des hommes et acquérir, voire outrepasser, leur autonomie. Les machines ne parviennent pas à modifier d’elles-mêmes le langage dans lequel s’expriment les observations qui alimentent leurs mécanismes d’apprentissage. En d’autres termes, elles ne peuvent être inventives et la performance étonnante des applications issues des algorithmes d’apprentissage sur de grandes masses de données ne tient pas à leur créativité.

Cette « fable extravagante » construite par le récit de la singularité est pour l’auteur un « détournement d’attention ». L’enjeu pour les acteurs industriels majeurs des hautes technologies n’est pas seulement économique : « il est aussi, et même avant tout, politique ». Ces acteurs défient les États constitués : « les attributions traditionnelles des États s’amenuisent, grignotées chaque jour davantage par l’appétit de ces grands groupes industriels, sans que personne ne s’y oppose ». C’est finalement un appel à l’action que revendique l’auteur du Mythe de la Singularité : agissons plutôt que de fermer les yeux. Agir, cela veut dire ne pas se laisser déposséder de notre capacité d’action politique, celle de construire par nos choix la société que nous voulons, celle de défendre l’intérêt général contre celui de quelques-uns, de moins en moins nombreux, qui décideraient pour nous. L’évolution technologique participe donc à sa manière à la construction de rapports de force de plus en plus inégalitaires, sauf si nous nous en saisissons comme d’un instrument au service de tous, comme l’ont rappelé les deux lettres ouvertes de 2015 (op. cit.).

Notes :

1. Le Mythe de la Singularité. Faut-il craindre l’intelligence artificielle ?, Seuil, 2017.

2. https://futureoflife.org/ai-open-letter/ ; https://futureoflife.org/open-letter-autonomous-weapons/

Voir dans la Web-revue sur le transhumanisme : Actualités #28, février 2015. Sur l’intelligence artificielle, Actualités #33, juillet-août 2015, et Actualités #53, mai 2017.

Annexe : Pour une intelligence artificielle maîtrisée, utile et démystifiée [1]

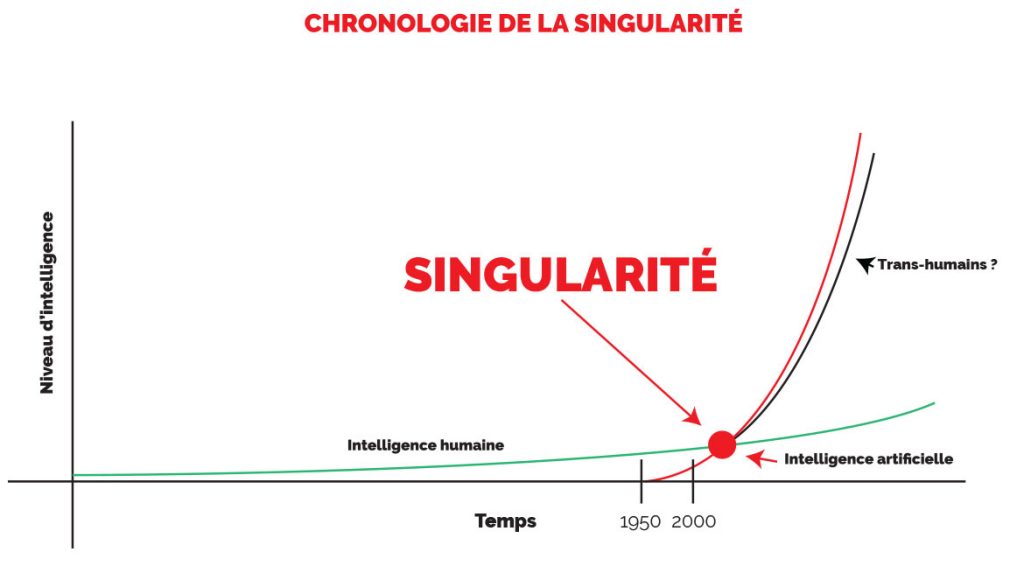

La rupture dite de la « singularité technologique » appelée aussi simplement singularité [2], est le nom que des écrivains et des chercheurs en intelligence artificielle ont donné au passage de l’IA faible à l’IA forte [3].

La singularité représente un tournant hypothétique supérieur dans l’évolution technologique, dont l’intelligence artificielle serait le ressort principal. [L’auteur de science-fiction, et universitaire] Vernor Vinge a rédigé un essai remarqué à ce sujet en 1993 [4].

De nombreuses œuvres de science-fiction ont décrit ce tournant, qui a été une source d’inspiration très riche pour le cinéma. Les films Terminator, Matrix, Transcendance sont des exemples de la « singularité technologique », qui est donc bien plus qu’une simple hostilité de l’intelligence artificielle, également souvent au cœur de l’intrigue des œuvres de science-fiction.

Les progrès en matière d’intelligence artificielle, en particulier avec le deep learning, sont parfois interprétés comme de bons augures de la singularité, mais rien ne permet de garantir la capacité à créer au cours des prochaines décennies une super-intelligence dépassant l’ensemble des capacités humaines. Par exemple, en s’appuyant sur la loi de Moore, Ray Kurzweil prédit que les machines rivalisant avec l’intelligence humaine arriveront d’ici à 2020 et qu’elles le dépasseront en 2045 [5]. D’après Raja Chatila, directeur de recherche à l’Institut des systèmes intelligents et de robotiques (Isir), nous en sommes, aujourd’hui, encore loin car « pour être intelligente comme un humain, une machine devra d’abord avoir la perception d’elle-même, ressentir son environnement, traiter des informations a flux continu et en tirer du sens pour ensuite agir […]. Ce n’est pas la technique qui fait défaut a la machine, mais le sens de ses actions, et l’intégration de la notion de concept ».

Notes de l’annexe

1. Extrait du rapport de l’Office parlementaire d’évaluation des choix scientifiques et technologiques du 15 mars 2017 par M. Claude De Ganay [LR], député, et Mme Dominique Gillot [PS], sénatrice (p. 195-196). https://www.senat.fr/rap/r16-464-1/r16-464-1_mono.html

2. En gras dans le rapport.

3. Des 1965, Irving John Good a décrit, en précurseur, la singularité, mais sans la nommer et ce, de la manière suivante : « Mettons qu’une machine supra-intelligente soit une machine capable dans tous les domaines d’activités intellectuelles de grandement surpasser un humain, aussi brillant soit-il. Comme la conception de telles machines est l’une de ces activités intellectuelles, une machine supra-intelligente pourrait concevoir des machines encore meilleures ; il y aurait alors sans conteste une explosion d’intelligence, et l’intelligence humaine serait très vite dépassée. Ainsi, l’invention de la première machine supra-intelligente est la dernière invention que l’homme ait besoin de réaliser. » Vernor Vinge a commencé à parler de la singularité dans les années 1980, et a formulé ses idées dans un premier article paru en 1993 intitulé « Technological Singularity ». Il y posait l’hypothèse que dans un délai de trente ans, l’humanité aurait les moyens de créer une intelligence surhumaine mettant un terme à l’ère humaine.

4. Cf. Vernor Vinge, The Coming Technological Singularity. How to survive in the post-human era (1993).

5. Les prédictions du futurologue [Kurzweil] peuvent être rappelées. Les ordinateurs atteindront une capacité de traitement comparable au cerveau humain en 2020. En 2022 les États-Unis et l’Europe adopteront des lois règlementant les relations entre les humains et le robot, l’activité des robots, leurs droits, leurs devoirs et autres restrictions seront fixes. En 2031, l’impression des organes humains par des imprimantes 3D sera possible. La circulation de véhicules autonomes sur les routes devient la norme en 2033. Immortalité de l’homme en 2042 et, enfin, la singularité en 2045.

Professeure à l’université de Lille en information-communication à l’université de Lille 3, et membre du laboratoire GERICO. Spécialiste des répercussions sociales et politiques des technologies numériques, elle est l’auteure de nombreux articles scientifiques.