La foi non intentionnelle en la technologie : sous-traiter le sens à l’intelligence artificielle – Avantika TEWARI

Cet article, traduit par moi, est paru dans Sublation magazine, le 10 sept. 2024 (DB).

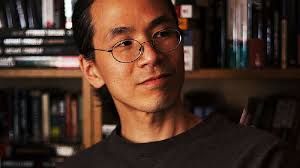

Les réflexions de [l’auteur de science-fiction] Ted Chiang (2024) sur le lien entre intelligence artificielle (IA) et créativité soulignent un souci profond : la réduction troublante de l’art et de l’expression créative à une simple série de choix mécaniques, facilités par des outils comme ChatGPT. Selon Chiang, l’IA opère comme un chariot élévateur dans une salle de musculation – un appareil en apparence utile qui, plutôt que renforcer nos capacités cognitives et créatives, risque de les atrophier. Il nous avertit qu’en automatisant des éléments de créativité, nous pourrions diminuer notre rôle de créateurs et d’interprètes du sens, transformant l’expérience riche et subjective de l’art en une ligne de production insipide.

Au cœur du malaise de Chiang est la tension entre les capacités naissantes de l’IA et la question philosophique de ce qui constitue « l’intelligence véritable ». Tandis que l’IA peut émuler certains aspects de la cognition humaine, il manque fondamentalement l’intentionnalité subjective qui définit la pensée vraiment créative. En abaissant nos attentes – que ce soit de l’art que nous consommons ou de notre propre potentiel créatif – l’IA menace de redéfinir non seulement l’art et l’intelligence, mais aussi l’essence même de ce qu’il veut dire d’être humain.

La critique faite par Chiang s’étend au-delà de la qualité de l’art généré par l’IA jusqu’aux implications sociales plus larges de l’adoption de l’IA comme partenaire créatif. Il affirme qu’appréhender l’IA comme outil à « améliorer et à aider » la créativité relève d’une idée profondément fausse. Une telle perspective s’accroche à l’illusion que l’IA n’est qu’une extension des capacités humaines, ne reconnaissant pas son potentiel de modifier complètement notre relation avec la créativité. L’opinion critique de Chiang met en question la croyance optimiste que l’IA puisse démocratiser la créativité ou élargir le potentiel humain.

L’art n’est pas simplement une série de choix délibérés, mais un processus complexe, souvent inconscient de prises de décisions que les algorithmes et les messages textuels ne peuvent pleinement englober. Cette notion fait écho au concept de philosophe Alain Badiou (2004) de la « pensée » comme quelque chose qui émerge à travers des ruptures avec la connaissance existante, plutôt que quelque chose de facilement systématisé ou de mécaniquement reproductible.

De façon similaire, Jacques Lacan voit le sujet comme un vide dans la connaissance, continuellement redéfini à travers des actes de création qui perturbent la compréhension courante. Dans cette perspective, l’acte créatif transcende le simple usage des outils ; il manifeste le vide subjectif dans les contraintes à la connaissance – quelque chose que l’IA, en tant que machine d’apprentissage, ne peut répliquer. La pensée n’est pas réductible à des lois objectives ou à des structures fixes, et son médium universel se trouve dans l’engagement avec les complexités provenant de l’intégration sociale.

Le vrai danger se trouve non seulement dans la banalité potentielle des contenus générés par l’IA, comme le craint Chiang, mais dans le déplacement culturel plus large vers la diminution de la valeur de l’intentionnalité humaine dans le processus créatif. De même que le capitalisme réduit le travail à une simple fonction au sein d’un système, l’IA réduit la créativité à un processus mécanique, l’enlevant de ses dimensions subjectives. La prétendue « égalité » entre les textes générés par l’IA et la créativité humaine porte moins sur la qualité intrinsèque de la production, et plus sur son rôle au sein d’un système qui privilégie l’efficacité et la productivité par rapport à l’expression artistique.

La logique dominante de l’IA, entrelacée avec les aspects symboliques et imaginaires de la subjectivité humaine, révèle une disjonction profonde entre désir et langage, s’étendant bien au-delà des limites des grands modèles de langage. Les mots, en dépit de leur usage répandu, manquent intrinsèquement d’englober le sens d’une manière complète et satisfaisante. Ce décalage souligne le besoin pressant d’authentifier les expériences – quelque chose que le langage, avec toutes ses capacités, a du mal à faire.

Suis-je ce que je dis que je suis ?

On considère souvent le langage comme un médium neutre ou bénin, façonné par l’intentionnalité humaine. La perspective fonctionnaliste suppose que le langage serve simplement de conduit transparent pour la représentation de la réalité. Elle suppose que le rôle du langage soit de fidèlement refléter la réalité, faisant de celle-ci un portrait juste de notre monde (Zizek, 2008).

Cependant, cette supposition néglige un aspect crucial : même quand nous partageons une réalité empirique, notre compréhension en est médiatisée par une représentation symbolique. Ce processus crée une gamme de « réalités » influencées par des interprétations plutôt que par une expérience immédiate sans filtre (Zizek, 2009). En effet, nous n’engageons pas directement avec la réalité immédiate des objets ou des évènements. Au lieu de cela, nous interagissons avec des réalités « fausses » – des déformations ou des constructions façonnées par des images symboliques. Celles-ci, bien que flexibles, encadrent et enferment en fin de compte la réalité perçue.

Dans ce contexte, l’IA génératif exacerbe cette question. Non seulement elle favorise une dépendance qui diminue notre engagement cognitif, mais elle reflète notre refoulement inconscient. Slavoj Zizek (2023) suggère que l’IA révèle les contenus refoulés de la conscience, tandis que Duane Rousselle (2023) affirme qu’elle met en miroir l’inconscient lui-même. Avantika Tewari (2023) prétend que l’IA matérialise une « tache », une manifestation du refoulement constitutif qui sépare notre réalité de l’artificialité, soutenant l’engagement à travers cette déformation. Vu ainsi, l’influence de l’IA ne se limite pas à la simplification ou à l’automatisation du travail, mais renforce un mode particulier d’engagement qui perpétue une réalité construite. L’IA souligne les déformations inhérentes dans nos systèmes symboliques qui façonnent comment nous percevons le monde.

Alors que l’IA peut trouver une niche au sein de l’économie créative, affirme Chiang, il ne peut répliquer l’intentionnalité et la création du sens qui font partie du travail artistique véritable. De même, les efforts des activistes dans le monde du design (Henry, 2023) d’inscrire l’intentionnalité dans le design technologique ne font que refléter l’empiètement de l’IA sur l’espace créatif, faisant écho à la réduction capitaliste du travail à une marchandise, plus que jamais dévalorisée. Dans ce contexte, les aspects uniques de la créativité humaine sont subordonnés aux demandes implacables du système de fonctionnalité immédiate.

Qui plus est, la corrélation entre intentionnalité et sens suggère que notre compréhension de la réalité est toujours médiatisée par des cadres cognitifs humains, soulignant que nos choix de mots et nos actions façonnent la perception. Pourtant, ce point de vue néglige souvent la déconnexion critique entre le langage et l’idéal de « l’intelligence créative » qui reste perpétuellement insaisissable. Dans les systèmes comme ChatGPT, cette déconnexion devient apparente. Ces systèmes génèrent des réponses fondées sur des modèles et des corrélations tirés de vastes jeux de données, mais qui se heurtent inéluctablement aux lacunes et aux inconsistances fondamentales que les algorithmes ne peuvent résoudre (Gewirtz, 2023).

Les limites structurelles et les « vices » inhérents de ces systèmes sapent l’illusion qu’ils donnent de cohérence et d’exhaustivité. Plutôt que de simplement refléter les imperfections inhérentes de la machine, ces vices soulignent une dynamique plus complexe – une qui révèle la tension entre les capacités limitées de l’IA et la nature incomplète et inconsistante de la subjectivité humaine. De même que rien dans l’univers ne peut prétendre à une existence indépendamment de son émergence microcosmique, le potentiel et les capacités de l’IA sont limités par ses algorithmes fondateurs, ses entrées de données, et ses contraintes développementales.

Ainsi, la promesse de l’IA de la rationalité et de la précision échoue quand elle se heurte aux éléments imprévisibles de l’interaction humaine, ce qui met en question ses prétentions à la compréhension totale. Le problème devient particulièrement évident quand on examine les tentatives d’intégrer le raisonnement symbolique (Platzer, 2024), par exemple l’analyse des sentiments sur les réseaux sociaux. Ces derniers répondent au besoin de distraction avec des plateformes qui moissonnent l’attention, mais ils ne peuvent mesurer l’ennui et le désenchantement qui en résultent (Read, 2014). Tandis que les systèmes de l’IA cherchent à en maintenir la cohérence et l’efficacité, ils sont aussi sujets à leurs limitations inhérentes et à un processus continu d’adaptation.

La jouissance au cœur du paradoxe de l’intentionnalité

La rapidité accélérée de production technologique dans le capitalisme des plateformes numériques a profondément modifié les rythmes traditionnels de travail et de créativité, transformant ceux-ci en un processus mécanisé qui privilégie les demandes du marché par rapport à l’intentionnalité de l’expression humaine.

L’IA n’est pas simplement un outil, mais une composante d’un système plus large qui redéfinit la créativité comme un mécanisme pour produire du plus-de-jouir dans l’économie numérique (Zizek, 1999). Ce déplacement reflète la logique capitaliste qui pousse le rôle de l’IA dans la créativité, où la focalisation passe de l’acte subjectif à la production des contenus consommables valorisés par le formulaire de données.

Cette interaction matérialise une interaction complexe de plaisir et de souffrance, s’étendant bien au-delà de la satisfaction. Les systèmes comme ChatGPT encouragent une forme de jouissance qui est à la fois expansive et superficielle. L’augmentation rapide des stimulants numériques facilités par l’IA mène à une vague de plaisirs fugaces. Ces plaisirs impliquent l’engagement avec les demandes du système pour l’interaction constante.

Ce débit implacable des contenus générés par l’IA peut être appréhendé comme une façon de « gérer » le vide subjectif par l’engagement. En fournissant de nouveaux contenus en continu, les systèmes de l’IA soutiennent un cycle d’engagement qui maintient les utilisateurs en état de dépendance. Cependant, cela pourrait échouer à aborder le vide constitutif. Cela reflète l’idée de Lacan que la poursuite de la jouissance compense souvent le manque inhérent dans le Sujet, ce qui se manifeste comme une pulsion d’insatisfaction numérique. Quant à eux, les utilisateurs s’engagent avec le système de manière à contribuer à un surplus de données, utilisé pour entraîner l’IA encore plus – une forme d’engagement zombie où les utilisateurs trouvent une jouissance paradoxale dans leur propre destitution.

Alors que ChatGPT fonctionne comme un outil de rationalisation, alignant le moi avec le système technoéconomique, il sert aussi de machine de suridentification, reflétant et amplifiant les contradictions inhérentes dans les désirs collectifs (Fidaner, 2024). Faisant écho à la notion lacanienne de destitution subjective, qui implique la réduction à un objet plutôt que la désujétion, cela résulte en une forme de déshumanisation (Zizek, 2023). Après avoir subi la destitution subjective, un sujet perd sa profondeur « humaine » – caractérisée par une vie intérieure riche –, devenant un pur vide. Cette réduction permet au sujet d’expérimenter des interactions d’une façon radicalement nouvelle, révélant un potentiel révolutionnaire par la création d’un vide dans l’étoffe de l’Histoire elle-même.

Références :

Badiou, Alain, “Eight Theses on the Universal”, 2004.

Chiang, Ted, “Why A.I. Isn’t Going to Make Art”, The New Yorker, 2024.

Fidaner, Isik Baris, “Humanity Can Create Realistic Utopias with the Help of Robots”, Zizekian Analysis, 2024.

Gewirtz, David, et Alyson Windsor, “6 things ChatGPT can’t do (and another 20 it refuses to do)” ZDNet, 16 February 2023.

Henry, Nicola, “A ‘design justice’ approach to developing digital tools for addressing gender-based violence: exploring the possibilities and limits of feminist chatbots.” Information, Communication & Society, 2024, pp. 1-24.

Platzer, Andre, “Intersymbolic AI: Interlinking Symbolic AI and Subsymbolic AI”, 2024.

Read, Jason, “Distracted by Attention” The New Inquiry, 18 déc. 2014.

Rousselle, Duane, “ChatGPT, From a Window in Baltimore” Sublation Magazine, 2023.

Tewari, Avantika, “I Chat, Therefore I am!”, Sublation Magazine, 2023.

Zizek, Slavoj, “ChatGPT Says What Our Unconscious Radically Represses”, Sublation Magazine, 2023.

Zizek, Slavoj, “Subjective destitution in art and politics: From being-towards-death to undeadness”, Enrahonar. An International Journal of Theoretical and Practical Reason, vol. 70, 2023, pp. 69-81.

Zizek, Slavoj, Violence: Big Ideas/Small Books. Pan MacMillan, 2008.

.